📝 Articolo: La Responsabilità nell’Intelligenza Artificiale: Etica, Rischi e Governance per un Futuro Affidabile

🔎 Etica e Trasparenza: Principi e Applicazioni

Esempio pratico: Un algoritmo utilizzato da un tribunale statunitense (COMPAS) per la valutazione del rischio di recidiva ha mostrato bias razziali sistematici, penalizzando i cittadini afroamericani. Questo dimostra come mancanza di trasparenza e assenza di auditing etico possano portare a discriminazioni gravi (ProPublica).

Criticità:

- Black-box models: la complessità di molti algoritmi impedisce la comprensione delle decisioni da parte di utenti e stakeholder.

- Responsabilità diffusa: chi risponde legalmente per una decisione automatizzata? Il programmatore, l’azienda, l’algoritmo?

👥 Coinvolgimento degli Stakeholder: Necessità di Inclusione

Esempio pratico: L’UE, con il regolamento sull’intelligenza artificiale (AI Act), ha promosso l’inclusione di stakeholder pubblici, privati e cittadini nel processo decisionale attraverso consultazioni pubbliche e tavoli tecnici.

Criticità:

- Asimmetria informativa: cittadini e consumatori spesso non hanno strumenti per comprendere o valutare l’uso dell’IA.

- Partecipazione superficiale: molte consultazioni pubbliche si limitano a procedure formali senza reale impatto sulle scelte progettuali.

⚠️ Gestione dei Rischi: Dai Principi alla Pratica

Esempio pratico: I veicoli autonomi rappresentano una tecnologia ad alto rischio. Nel 2018, un’auto a guida autonoma Uber ha causato la morte di una donna in Arizona. L’incidente ha messo in luce gravi lacune nei protocolli di sicurezza e nella supervisione tecnica del software.

Criticità:

- Imprevedibilità dell’apprendimento automatico: modelli complessi possono comportarsi in modo inatteso, specialmente in ambienti dinamici.

- Assenza di standard condivisi: mancano ancora parametri universalmente accettati per valutare la sicurezza dell’IA in fase di test e in ambito reale.

📜 Normative e Governance: Regolamentare per Prevenire

Esempio pratico: L’AI Act europeo classifica i sistemi IA in base al loro livello di rischio (basso, alto, inaccettabile) e stabilisce obblighi stringenti per quelli ad alto rischio, come i sistemi di riconoscimento facciale.

Criticità:

- Gap normativi internazionali: mentre l’Europa ha avviato una regolamentazione rigorosa, USA e Cina seguono logiche molto diverse.

- Eccesso di burocrazia: regole troppo complesse possono soffocare l’innovazione, specialmente per le PMI.

🎓 Cultura della Responsabilità: Educare per Governare

Esempio pratico: Il MIT ha sviluppato il progetto “Moral Machine”, una piattaforma online che simula dilemmi etici per veicoli autonomi, allo scopo di educare il pubblico e raccogliere dati utili alla progettazione di sistemi IA.

Criticità:

- Diffusione disomogenea della formazione: molti sviluppatori IA non ricevono adeguata educazione etica o giuridica.

- Responsabilità aziendale spesso solo “di facciata”: le dichiarazioni etiche non sempre si traducono in reali processi di accountability.

🧠 Etica e Bias Algoritmici: il caso COMPAS

Uno degli esempi più noti di mancanza di responsabilità e trasparenza è quello del sistema COMPAS (Correctional Offender Management Profiling for Alternative Sanctions), usato in alcuni stati americani per valutare il rischio di recidiva dei detenuti.

Problema:

Un’inchiesta di ProPublica ha dimostrato che l’algoritmo discriminava sistematicamente le persone nere, attribuendo loro punteggi di rischio più alti rispetto ai bianchi in condizioni simili, pur senza accesso ai dati razziali diretti (ProPublica).

Criticità evidenziate:

- Nessuna spiegabilità del modello (black-box totale).

- Nessun meccanismo di accountability o revisione indipendente.

- Conseguenze legali gravi su persone reali.

🚗 Rischi e Responsabilità: Uber e il primo incidente mortale causato da un’IA

Nel 2018, un veicolo autonomo di Uber ha investito e ucciso una donna a Tempe, Arizona. L’auto era in modalità autonoma, ma il sistema non aveva rilevato correttamente un pedone che stava attraversando fuori dalle strisce pedonali.

Risultato:

- Uber ha sospeso i test per mesi.

- Il software di rilevamento era stato programmato per ignorare falsi positivi, ma questo comprometteva la sicurezza.

- L’assenza di una politica chiara di intervento umano ha sollevato domande sulle responsabilità civili e penali.

Insegnamento:

La responsabilità condivisa tra programmatori, aziende e supervisori umani non era definita, generando confusione anche a livello giuridico (NTSB Report).

🎓 Cultura della responsabilità: il progetto “Moral Machine” del MIT

Per promuovere il dibattito sulla moralità nelle decisioni autonome, il MIT ha lanciato Moral Machine, un sito web interattivo dove milioni di utenti da tutto il mondo sono stati chiamati a decidere in dilemmi etici legati alla guida autonoma (es. salvare il passeggero o il pedone?).

Risultato:

- Oltre 40 milioni di decisioni raccolte da 200 Paesi.

- Enormi differenze culturali nei giudizi morali.

- Ha evidenziato quanto sia complesso definire comportamenti etici universali.

👉 Questo è un esempio di buona pratica partecipativa, utile per guidare lo sviluppo responsabile dell’IA (Moral Machine).

🏥 IA in Sanità: Watson for Oncology

IBM Watson for Oncology è stato un progetto ambizioso per supportare oncologi nella scelta delle terapie. Tuttavia, in più contesti è stato ritirato perché:

- forniva consigli clinici non affidabili,

- i medici non comprendevano i criteri con cui Watson prendeva le decisioni,

- il sistema non era aggiornato con i dati clinici più recenti.

Lezioni imparate:

- Necessità di trasparenza e supervisione umana continua.

- L’intelligenza artificiale non può sostituire il giudizio clinico senza compromessi.

📚 Fonte: Stat News

⚖️ Normativa europea: AI Act come riferimento globale

Nel 2021, la Commissione Europea ha proposto l’AI Act, il primo regolamento al mondo che classifica i sistemi di IA secondo il loro livello di rischio:

- Rischio inaccettabile: vietati (es. social scoring come in Cina).

- Rischio alto: richiede requisiti stringenti (es. IA in sanità, giustizia, assunzioni).

- Rischio limitato o minimo: soggetto a obblighi informativi o nessuno.

👉 L’AI Act prevede audit obbligatori, registri di trasparenza e sorveglianza attiva da parte degli Stati membri (European Commission).

🧩 Conclusioni: Per un Futuro Affidabile

L’intelligenza artificiale può rappresentare una risorsa straordinaria per la società, ma solo se accompagnata da una visione responsabile e lungimirante. Servono:

- Protocolli trasparenti

- Standard di responsabilità condivisi

- Educazione diffusa

- Regole armonizzate tra Paesi

“La fiducia nell’intelligenza artificiale non può essere cieca: deve essere costruita su una base di responsabilità solida, verificabile e partecipata.” – AI4People

📚 Fonti di Approfondimento

- ProPublica – Machine Bias

- European Commission – AI Act

- Stanford – AI100 Report 2023

- IEEE – Ethically Aligned Design

- Future of Life Institute – AI Principles

- AI Now Institute – Accountability Frameworks

🖼️ Immagine Utilizzata

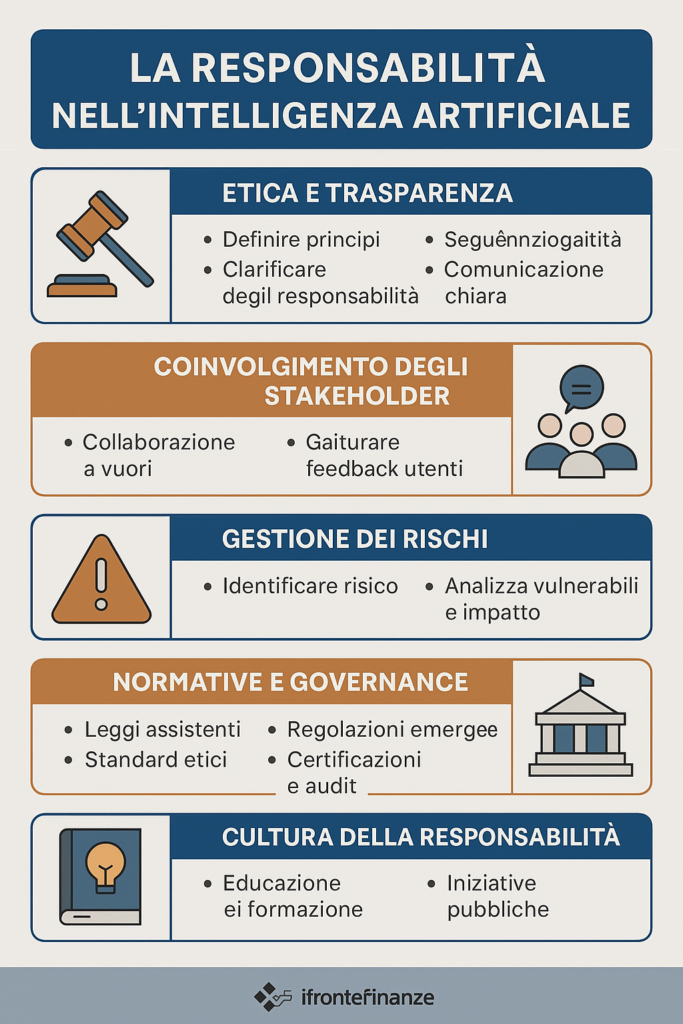

(vedi immagine mappa concettuale allegata: “Responsabilità nell’IA”)

Responsabilità e Trasparenza nell’Intelligenza Artificiale: Verso un Futuro Etico

In questo episodio, Ivano Esposito esplora l’uso dell’Intelligenza Artificiale per raccontare se stessa, affrontando le sfide della responsabilità, dell’etica e della governance. Si discute della necessità di trasparenza nei sistemi di IA, dei rischi associati come nel caso degli algoritmi bias e dei veicoli autonomi, nonché dell’importanza di un coinvolgimento efficace degli stakeholder. Si sottolinea come un approccio equilibrato e condiviso possa costruire la fiducia e garantire un futuro affidabile per l’IA.

Script del podcast

Giulia

Giulia

Allora, oggi voglio portarvi in un viaggio affascinante nel mondo dell’Intelligenza Artificiale, o AI, e scopriremo insieme come essa possa davvero raccontare le sue storie. Questo argomento si sposa perfettamente con il titolo “Responsabilità nell’Intelligenza Artificiale: Etica, Rischi e Governance per un Futuro Affidabile.” Che ne pensi?

Luca

Luca

Uhm, sì! Ma aspetta, come può l’AI ‘raccontare’ se stessa? Mi sto immaginando un robot narratore, come in un film. È una cosa così reale?

Giulia

Giulia

Esattamente! Immagina un’intelligenza artificiale che non si limita a fornire dati, ma ci spiega le scelte che ha fatto e le implicazioni etiche dietro di esse. Prendi i sistemi di giustizia penale come esempio. Un algoritmo di valutazione del rischio potrebbe contenere pregiudizi razziali, e ci sono stati casi negli Stati Uniti dove questo è stato chiaramente dimostrato. Uhm, non ti sembra inquietante?

Luca

Luca

Oh wow, sì! Ma perché succede? Non dovrebbero programmare l’AI in modo da evitare questi pregiudizi, o sbaglio?

Giulia

Giulia

Ottima osservazione! La mancanza di trasparenza nei dati è una delle sfide principali. Se non conosciamo l’origine dei dati, il rischio di discriminazione aumenta. È come navigare in un oceano senza una mappa. Infatti, l’Unione Europea cerca di coinvolgere i vari stakeholder tramite consultazioni pubbliche, ma… umm, a volte sembra che non abbiano voce in capitolo, giusto?

Luca

Luca

Hmm, interessante! Quindi gli stakeholder sono come i consulenti di un progetto, ma non vengono ascoltati? È un po’ come quando cerchi di convincere amici a provare un ristorante di sushi vegano. È così difficile!

Giulia

Giulia

Esattamente! E il problema si amplifica quando consideriamo la gestione dei rischi. Pensa ai veicoli autonomi, hanno un potenziale enorme, ma il tragico incidente di un’auto Uber nel 2018 ha rivelato gravi lacune nei protocolli di sicurezza. Uhm, chi è responsabile se un’auto a guida autonoma provoca un incidente?

Luca

Luca

Sì! È così complicato! Qualcuno deve assumersi la responsabilità, ma come diavolo si fa a decidere chi sia? Ma parliamo delle leggi, ci sono normative specifiche per l’AI?

Giulia

Giulia

Ah, ottima domanda! Sì, l’AI Act dell’Unione Europea classifica i sistemi di AI in base ai loro livelli di rischio e stabilisce obblighi per i sistemi ad alto rischio, come il riconoscimento facciale. Ma… umm, ci sono ancora lacune normative a livello internazionale. Immagina di viaggiare in un paese dove le leggi sull’AI sono completamente diverse. Ti fa sentire come in un film di fantascienza, no?

Luca

Luca

Esattamente! È come se fossimo in un universo parallelo, dove le stesse macchine seguono leggi diverse ovunque. E il fatto di creare questa “cultura della responsabilità” è così cruciale! Ma come possiamo farlo concretamente?

Giulia

Giulia

Un esempio illuminante è il progetto ‘Moral Machine’ del MIT. Simula dilemmi etici per educare i consumatori sulle decisioni autonome. Ti fa capire come le differenze culturali influenzino i giudizi morali, che è incredibile! Uhm, immagina se un’auto deve scegliere tra salvare un pedone o il suo conducente; come deciderebbe in base alla cultura locale?

Luca

Luca

Oh wow! È come se ognuno di noi avesse un’idea diversa su cosa sia giusto o sbagliato! E riguardo all’AI in medicina? Ho sentito dire che IBM Watson per l’oncologia non può sostituire completamente il giudizio clinico. È vero?

Giulia

Giulia

Esattamente! L’AI è uno strumento straordinario, ma senza supervisione umana e trasparenza, può fare errori. È come avere un assistente che non conosce mai veramente le esigenze del paziente, ma si basa solo su dati generali. Uhm, non vorresti che il tuo medico si basasse solo su quelli, giusto?

Luca

Luca

No, decisamente no! Quindi alla fine, si tratta di fiducia nell’AI, giusto? Dobbiamo costruirla su una base solida e condivisa, esatto?

Giulia

Giulia

Esattamente! Se vogliamo che l’AI diventi una risorsa straordinaria, è fondamentale che sia supportata da protocolli trasparenti e standard di responsabilità. Solo così potremo affrontare le sfide etiche e normare il suo uso nel futuro. Uhm, ci sono così tante cose da considerare, ma ci riusciremo!

Luca

Luca

[sigh] Wow, questo è davvero un argomento vasto! Ma mi piace, voglio sapere di più! È come un labirinto di idee!